A világon második országként Kanada hétfőn vizsgálatot indított a ChatGPT-t fejlesztő OpenAI ellen a személyes adatok átláthatatlan kezelése miatt. Egy héttel ezelőtt Olaszország hasonló aggodalmak miatt már teljesen blokkolta a ChatGPT elérését, a mesterséges intelligenciát (MI) lakossági szinten forradalmasító program így ideiglenesen nem is érhető el náluk.

A trend azt jelzi, hogy a ChatGPT-t elsősorban a személyes adatok problémáján keresztül látják megfoghatónak a hatóságok. A potenciális problémák ennél ugyanakkor jóval szélesebbek, ahogy természetesen az MI-ben rejlő lehetőségek is.

A közelmúltban 5000 kutató, fejlesztő és tech-guru, köztük Elon Musk és Steve Wozniak írta alá azt a nyílt levelet, mely az AI-rendszerek komoly veszélyei miatt azt szorgalmazza, hogy fél évre, a kockázatok pontosabb megértéséig és a szabályozás megalkotásáig függesszenek fel minden kapcsolódó fejlesztést. Egy ilyen globális moratóriumra azonban sem a tech-cégek közötti versenyfutás, sem a Kína és Amerika közötti versengés miatt nem látszik egyelőre túl sok esély.

Az Egyesült Államokban Biden elnök hétfőn találkozott tudományos és technológiai tanácsadóval. Ezután ugyan meglehetősen óvatosan nyilatkozott a mesterséges intelligenciában rejlő előnyökről és kockázatokról, a fő konkrétum inkább csak annyi volt, hogy újra felszólította a Kongresszust, hogy dolgozzon a kétpárti adatvédelmi törvényen a gyűjtött személyes adatgyűjtés szabályozásáért (korábban az amerikai Kereskedelmi Kamara szólított fel MI-szabályozásra a nemzetbiztonsági kockázatok csökkentése érdekében), de az amerikai elnök megszólalása így is elég volt ahhoz, hogy több, mesterséges intelligenciában utazó fejlesztő cég részvényárfolyama 10-30 százalékot zuhanjon a hatására.

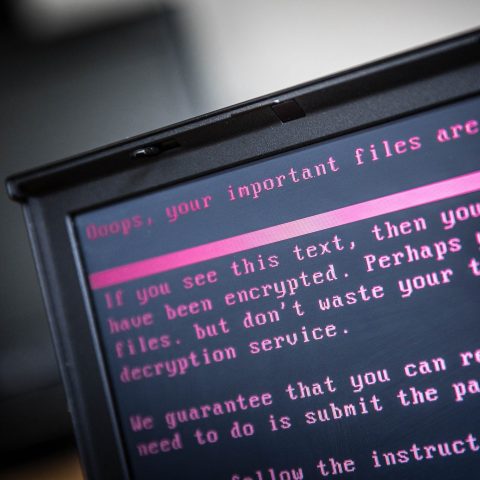

Az OpenAI elleni kanadai vizsgálatot megalapozó panasz a “személyes adatok beleegyezés nélküli gyűjtéséről, felhasználásáról és nyilvánosságra hozataláról” szólt. A fő kérdés, hogy a ChatGPT milyen adatokat gyűjt a felhasználóktól, és azokat hogyan kezeli.

A mesterséges intelligencia alapú algoritmusokat nagyméretű adatbázisokon, jelentős részben online szövegeken tanítják be, és később, a használat során is folyamatos lehet a későbbi adatok felhasználása – a keresőkérdések, felhasználókkal való kommunikáció révén fejlődik az algoritmus.

Ez az önkorrekció az, ami segíthet kiküszöbölni a bosszantó és/vagy vicces hibákat, arról ugyanakkor lényegében nincs nyilvános információ, hogy ezeket az adatokat pontosan hogyan használják fel. Így egyelőre arra sincs garancia, hogy a mesterséges intelligenciával folytatott csetelésben megosztott információknak, melyek között érzékeny adatok is szerepelhetnek, mi a sorsa.

A kérdés legélesebben az olasz adatvédelmi hatóság vizsgálatában jött elő, ami aztán a ChatGPT teljes blokkolásához vezetett – az olaszországi felhasználók a gyakorlatban így most csak VPN-en keresztül tudják elérni a ChatGPT-t.

“A mesterséges intelligencia olyan technológia, amely éppoly értékes, mint amennyire potenciálisan veszélyes. Ami engem aggaszt, az a szabályok hiánya”

– indokolta a döntést Pasquale Stanzione, az olasz adatvédelmi hatóság elnöke.

A hatóság egy másik tagja, Guido Scorza egy saját kísérletéével szemléltette a veszélyeket: egy másik MI-algoritmus, a szintén ideiglenesen betiltott Replikán egy 11 éves gyereknek adta ki magát, majd szexuális tartalmú kérdéseket tett fel és képeket küldött, a chatbot pedig beszámolója szerint arra buzdította, hogy még több gyermekpornográf képet küldjön.

“Itt nagyon személyes adatokról beszélünk. Amikor az emberek a ChatGPT-vel beszélgetnek, sokat elárulnak magukról, gyakran többet, mint amennyinek tudatában vannak. Sokan használják az alkalmazást tanácsadóként, akár orvosi, pszichológiai vagy jogi információkat osztva meg magukról”

– részletezte a veszélyeket egy interjúban Sforza.

Az olasz hatóságok erősen hangsúlyozzák, hogy nem az MI-fejlesztések megállítása a cél, de a cégeknek sokkal átláthatóbban kell informálniuk a felhasználókat az adatkezelési gyakorlatukról. “Az adatot szolgáltató személynek joga van értesülni arról, hogy mi történik ezekkel az információkkal – például, hogy az adatokat egy algoritmus továbbfejlesztésére használják fel” – érvelnek, mondván, lehetőséget kell biztosítani arra, hogy ezt az ember megtagadhassa.

A internetes személyes adatvédelem ügyét némileg nehezíti, hogy nagyon sokan szkeptikusak, mondván, a nagy tech-cégek és platformtulajdonosok legfőbb bevételi forrása az uralkodó üzleti modellben úgyis a felhasználói adatok értékesítése, ugyanezt teszi többek között a Google és a Facebook is.

Az olasz hatóságok szerint ugyanakkor alapvető különbség, hogy a Google-nél a felhasználónak ehhez legalább hozzá kell járulnia, és ezt akár meg is tagadhatja – miközben a ChatGPT-nél erre jelenleg nincs semmilyen lehetőség, és az OpenAI nem is árul el sokat arról, hogy az adatokat hogyan használja fel. Emiatt Rómából egy sor, az adatkezelésre vonatkozó kérdést küldtek nekik, ezekre az OpenAI-nek húsz napja van válaszolni. Az első megbeszélést szerdánt tartják.

A tágabb kérdés, hogy Olaszország (és talán Kanada) után más országok is követik-e a szigorúbb hatósági fellépést. Feltehetően most minden ország szorosan követi az eseményeket, és hasonló kérdéseket fogalmaz meg az OpenAI felé. A német adatvédelmi hatóság ugyanakkor már jelezte, hogy nem kíván a tiltás útjára lépni, EU-s szinten pedig előbb el kellene fogadni azt a mesterséges intelligencia szabályozást, amit a Bizottság még két éve kezdeményezett.

Tech

Fontos