Senki sem tudja, miért tűnhetett jó ötletnek elkészíteni az appot, ami bárkit levetkőztet. A DeepNude rendkívül egyszerű dologra volt képes: adtak neki egy bikinis képet, és a programot futtató számítógép erőforrásaitól függően fél-egy perc alatt levette a bikinit a képről. Esetleg a bugyit is. Ezt eddig bármelyik jobb Photoshop mester is meg tudta tenni. Emellett a DeepNude elvben teljes ruhákat is el tudott tüntetni. A gyakorlatban azonban ezeknél már gyakorta hibázott az algoritmus.

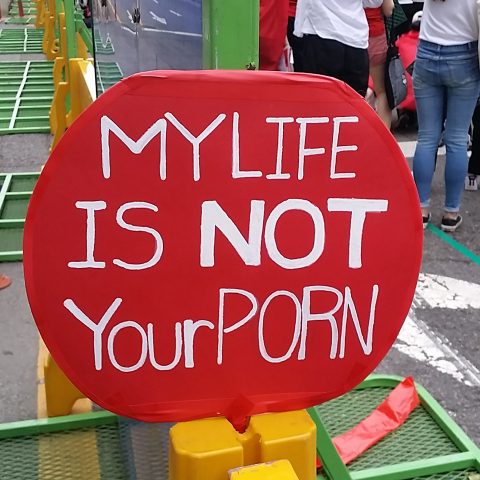

A megvalósítás minősége, a tanításra használt adatbázis milyensége – a férfiak vetkőztetésére lényegében alkalmatlan volt – azonban mellékszál. A DeepNude két technológiai jellegű tanulsággal szolgál. Az egyik, hogy nincs az az előre megjósolhatóan visszaütő rossz ötlet, amit ne tartana valaki zseniálisnak. A másik, hogy a szabadon elérhető gépi tanulási, gépi látási eszközök tökéletesen alkalmasak arra, hogy bárki gyártson vetkőztetős appot. A harmadik, társadalmi jellegű tanulság pedig, hogy a felek beleegyezése nélküli szexuális jellegű tettek – ennek a skálának a végén a nemi erőszak van – tárháza tovább tud bővülni.

A DeepNude-dal szembeni fellépés arra volt jó, hogy a programozó törölte az alkalmazást a netről. Fájlmegosztó hálózatokon azonban még fel-felbukkan, illetve legalább féltucatnyi különböző projekt van a program újraírására. Emellett természetesen megjelentek még olyan zavarosban halászók is, akik kártevőket kínálnak DeepNude telepítőként. Most épp kevés akkora ostobaság van, mint különböző, a neten kísérletező vetkőztető appokkal próbálkozni.

Olyan, mint a hidra

A deepfake technológia először 2017-ben tűnt fel. Képeket manipulálni korábban is lehetett mesterséges intelligencia eszközökkel, de azok kevésbé voltak látványosak. A legnépszerűbb, a Google által közzétett DeepDreap eszközzel csápokat és további szemeket lehetett növeszteni a képek szereplőire. Ez jó móka volt, de annak a megértéséig a felhasználóknak valószínűleg csak a kisebb százaléka jutott el, hogy a csápok és szemek nem a mesterséges intelligencia “álmai”, hanem abból fakadnak, hogy egy állatokat tartalmazó képi adatbázison tanították be a neurális hálót. Ha az állatok helyett építészeti fotográfiákkal etetik a gépet, akkor csúcsíveket és huszártornyokat rajzolt volna mindenre.

Ez a kép medúzaként kezdte a pályafutását (Fotó: MartinThoma)

A deepfake arra volt jó, hogy rádöbbentse az embereket, hogy nem csak látványos, de hol vicces, hol Hieronymus Bosch-t idéző torzításokra is használható a képmanipuláció. Arra is jó, hogy megtanítsuk a gépet, hogy egy forrásfájlon csak részeket cseréljen. Így bárki belekerülhet egy pornófilmbe, ha van róla elég fotó. Egy politikussal olyasmit is ki lehet mondatni egy videofelvételen, amit valójában akkor sem mondana, ha a nyelvét kellene leharapnia.

Kezdetben a fő félelem nem a bosszúpornós vagy meztelenítős felhasználás volt, hanem az, hogy a hamis hír (fake news) ipar fog visszaélni vele. A félelem alaptalannak bizonyult, az álhírek terjedéséhez nem kellett hamisított videós bizonyíték, megtette egy-egy évekkel korábbi, kontextusából kiemelt kép is. A pornós hamisítványokhoz a pornóipari szereplők változatos módon álltak hozzá. A Pornhub*Az egyik legnépszerűbb, felnőtt-tartalmak megosztására alapított oldal nem közös megegyezésen alapulóan létrehozott tartalomként kezelte és tiltani kezdte ezeket a klipeket, az EroMe szerint viszont ezek paródiák, és emiatt a szólásszabadság ernyője alá esnek.

Nem a bíróságon dől el

Világszerte vannak már próbálkozások a deepfake technológia korlátozására. Az amerikai Virginia államban például egyszerűen be is tiltották a deepfake videókat még februárban. Ugyanez az állam tiltotta be a bosszúpornó videókat*Olyan felvételek, amelyeket egy párkapcsolati szakítás után ömlesztenek a netre megszégyenítési vagy zsarolási céllal. is még korábban. A deepfakek tiltására készül New York is, de ebben az ügyben furcsa ellenfele támadt a törvényhozásnak. Az amerikai mozifilmes jogvédő szervezet, az MPAA jelezte, hogy túl szigorúnak érzik a törvénytervet. Az érdekvédő szervezet attól tart, hogy a deepfake és deepnude felvételekkel együtt az elhunyt színészekről készült felvételek felhasználásával készített élethű animációkat is eléri a tiltás.

A jelenség Magyarországon is létezik, ám amikor egy korábbi cikkhez megkérdeztem a Patent Egyesületet, akkor arról informáltak, hogy bár léteznek szexuális kényszerítési, zsarolási és bosszúpornó ügyek, ezek a bíróságon nem jelennek meg. A deepnude klipekről megkérdeztük Ormós Zoltán internetes ügyekben jártas ügyvédet is, aki szerint a kedvezőtlen megítélést keltő klipek közzététele a rágalmazás, becsületsértés tényállásai alá sorolhatók. Ugyanakkor ezekben az ügyekben a rendőrségnek kell nyomozni, és könnyen elképzelhető, hogy az eredeti feltöltőt nem lehet megtalálni. Ormós saját praxisában még nem fordult elő deepfake per, ellenben érdeklődésekkel már találkozott, ezeket a sértetteket a rendőrség felé irányította.

Problémát okoz azonban, hogy a szó hagyományos értelmében a deep fake készítése tényleg csak egy technológia, amely sok apró legódarabból áll, amiből építkezni lehet. A deepfake eljárással létrehozott rágalmazásra, hitelrontásra használt felvételekkel szemben el lehet járni. Ehhez azonban talán új törvényekre sincs szükség. Viszont arra nincs semmilyen garancia, hogy nem épít bárki, aki ért a neten talált kóddarabok és programkönyvtárak újrahasznosításához, egy újabb DeepNude appot. A képfelismerési és képmódosítási technológiát, ami az önvezető autóktól kezdve a Snapchat vicces maszkjain át egészen az új iPhone operációs rendszerének videotelefonjáig mindenhová beépült, nem lehet csak úgy kidobni. Emiatt nagyon nehéz lesz korlátozni, szabályozni a használatát.

Tech

Fontos